Суперкомпьютер анализирует веб-трафик по всему интернету

Моделирование веб-трафика может помочь в области кибербезопасности, проектирования вычислительной инфраструктуры, Интернет-политики и многое другое.

Понимание шаблонов веб-трафика в таком огромном масштабе помогает информировать интернет-политику, выявлять и предотвращать сбои, защищаться от кибератак и разрабатывать более эффективную вычислительную инфраструктуру.

Аналогичный подход был разработан учеными MIT в сотрудничестве с проектом широко интегрированной распределенной среды (WIDE), основанным несколькими японскими университетами, и Центром прикладного анализа интернет-данных (CAIDA) в Калифорнии с использованием суперкомпьютерной системы. Ученые разработали модель, которая фиксирует, как выглядит веб-трафик по всему миру в определенный день. Ученые считают, что модель может быть использована в качестве инструмента измерения для интернет-исследований и многих других приложений.

Используя массивный набор сетевых данных, модель может генерировать статистические измерения того, как все соединения в сети влияют друг на друга. Более того, эти меры могут помочь ученым определить понимание однорангового обмена файлами, злонамеренных IP-адресов и поведения спама, распределения атак в критических секторах и узких мест трафика, чтобы лучше распределять вычислительные ресурсы и поддерживать поток данных.

Джереми Кепнер, исследователь из суперкомпьютерного центра MIT Lincoln Laboratory, сказал: «Мы создали точную модель для измерения фона виртуальной вселенной Интернета. Если вы хотите обнаружить какие-либо отклонения или аномалии, у вас должна быть хорошая модель фона».

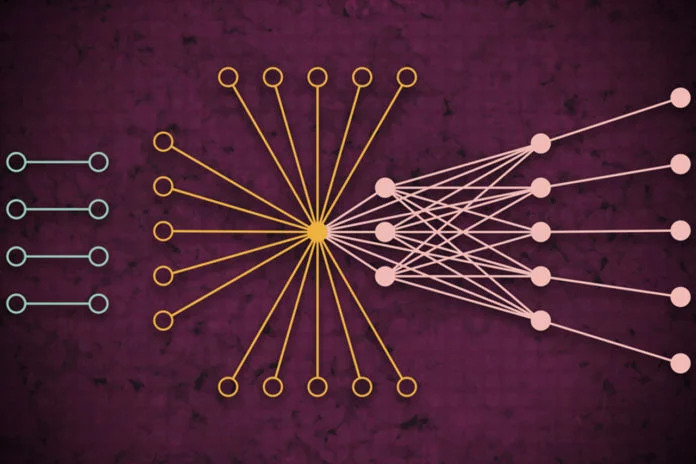

Для разработки этой модели ученые прежде всего собрали самый большой общедоступный набор данных интернет-трафика, который включает в себя 50 миллиардов пакетов данных, которыми обмениваются в разных точках земного шара в течение нескольких лет. Затем они отправили данные через уникальный тип конвейера нейронной сети, работающего на 10 000 процессоров MIT SuperCloud. Этот конвейер автоматически обучал модель, которая фиксирует взаимосвязь для всех ссылок в наборе данных - от обычных пингов до гигантов, таких как Google и Facebook, до редких ссылок, которые только ненадолго соединяются, но, кажется, оказывают некоторое влияние на веб-трафик.

Перед обучением любой модели на данных, ученые должны были сделать намного больше исследований. Для этого они использовали программное обеспечение, названное Dynamic Distributed Dimensional Data Model (D4M), которое использует некоторые методы усреднения для эффективного вычисления и сортировки «гиперразделенных данных», которые содержат гораздо больше места, чем точки данных.

Затем данные были разбиты на блоки с 100 000 пакетов на 10000 процессорах MIT SuperCloud. Это создало более компактные матрицы миллиардов строк и столбцов взаимодействия между источниками и пунктами назначения.

Тем не менее подавляющее большинство ячеек в этом гиперразделенном наборе данных были еще пустыми. Чтобы обработать матрицы, команда запустила нейронную сеть на тех же 10000 ядрах. За кулисами метод проб и ошибок начал подгонку моделей ко всем данным, создавая распределение вероятностей потенциально точных моделей.

Затем ученые обеспечили, чтобы модель могла собирать огромное количество данных, используя модифицированную технику исправления ошибок для дальнейшего уточнения параметров каждой модели.

Кепнер сказал: «В конце концов, нейронная сеть по существу генерирует простую модель, имеющую только два параметра, которые описывают набор данных интернет-трафика, от действительно популярных узлов до изолированных узлов, и полного спектра всего, что между ними».

Документ, описывающий подход, был представлен на недавней конференции IEEE High-Performance Extreme Computing Conference.