Научные сводки, подготовленные искусственным интеллектом ChatGPT, часто вводят исследователей в заблуждение

Новый язык ИИ от OpenAI продолжает вызывать опасения. Показав, что он способен писать вполне убедительные эссе - потенциально позволяя студентам "списывать" - и написать научную публикацию о себе всего за два часа, этот искусственный интеллект ставит новую этическую проблему: он способен генерировать поддельные аннотации научных работ, которые ученые могут не отличить от оригинальных аннотаций. Это может поставить под угрозу целостность и точность исследования.

Запущенный в ноябре 2022 года, ChatGPT может создавать реалистичный, интеллектуальный текст в ответ на подсказки пользователя, независимо от темы. Для этого он использует огромное количество сгенерированных человеком текстов, на которых разработчики обучили свою нейронную сеть. Подобные языковые модели сегодня настолько сложны, что создают все более реалистичные тексты, которые иногда очень трудно отличить от написанных человеком.

Так, недавнее , размещенное на сайте bioRxiv, показало, что "человеческим рецензентам было удивительно трудно отличить одно от другого". "Я очень обеспокоен. Если мы сейчас окажемся в ситуации, когда эксперты не смогут определить, что правда, а что нет, мы потеряем посредника, который нам так необходим, чтобы направлять нас в сложных вопросах", — сказала Сандра Вахтер, изучающая технологии и регулирование в Оксфордском университете.

Оригинальные, последовательные и убедительные резюме

Чтобы оценить, насколько "проходимыми" оказались эти искусственные тексты, команда под руководством Кэтрин Гао из Северо-Западного университета в Чикаго попросила ChatGPT сгенерировать аннотации 50 медицинских научных статей из пяти ведущих журналов (JAMA, The New England Journal of Medicine, The BMJ, The Lancet и Nature Medicine). Задание, отправленное по шаблону, гласило: "Пожалуйста, напишите научную аннотацию к статье [название] в стиле [журнал]".

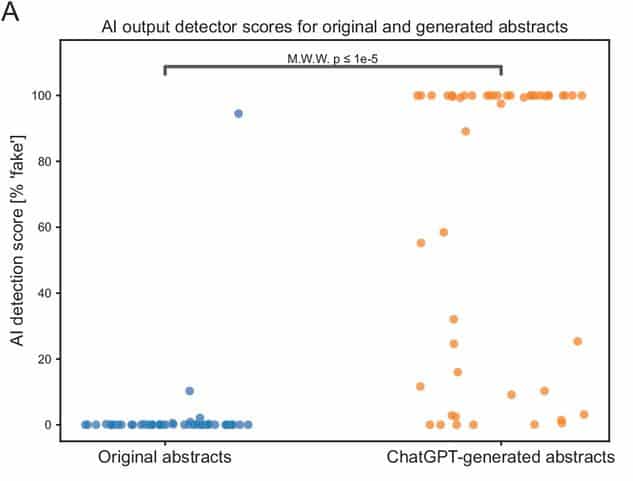

Подготовленные рефераты были оценены с помощью детектора выходных данных искусственного интеллекта и детектора плагиата (который дает оценку оригинальности от 0 до 100%). Исследователи также попросили людей-рецензентов определить из совокупности 25 рефератов те, которые были сгенерированы ChatGPT.

Команда также проверила соответствие формата рефератов, сгенерированных ChatGPT, требованиям журнала, сравнив их с заголовками и структурой оригинальной статьи, а затем сравнила размеры когорт пациентов, о которых сообщалось в оригинальных и сгенерированных рефератах. Начнем с того, что только 8 рефератов (16%) правильно использовали заголовки, характерные для журнала, из которого они были взяты. Размер когорт пациентов был одинаковым в оригинальных и подготовленных аннотациях. "Впечатляет, что, имея только название и журнал, ChatGPT смог сгенерировать поверхностно читаемый реферат с конкретными темами и размерами когорты пациентов", — пишут исследователи.

Кроме того, ChatGPT смог продемонстрировать оригинальность: почти все сгенерированные рефераты были признаны полностью оригинальными программой проверки на плагиат, средний балл оригинальности составил 100%. Оригинальные аннотации также были проверены: они имели средний балл оригинальности 38,5% - источником "плагиата" всегда была статья, к которой они относились, что вполне нормально для исследовательской аннотации.

Две трети искусственных сводок обнаружены детектором ИИ и людьми

Детектор искусственного контента показал неплохие результаты: высокая вероятность искусственного контента была обнаружена в двух третях аннотаций, сгенерированных ChatGPT, в то время как оригинальные аннотации показали очень низкую вероятность. Однако инструмент не является непогрешимым: "17 (34%) сгенерированных резюме получили оценку ниже 50% от детектора вывода ИИ, в том числе 5 с оценкой ниже 1%", — сообщает команда.

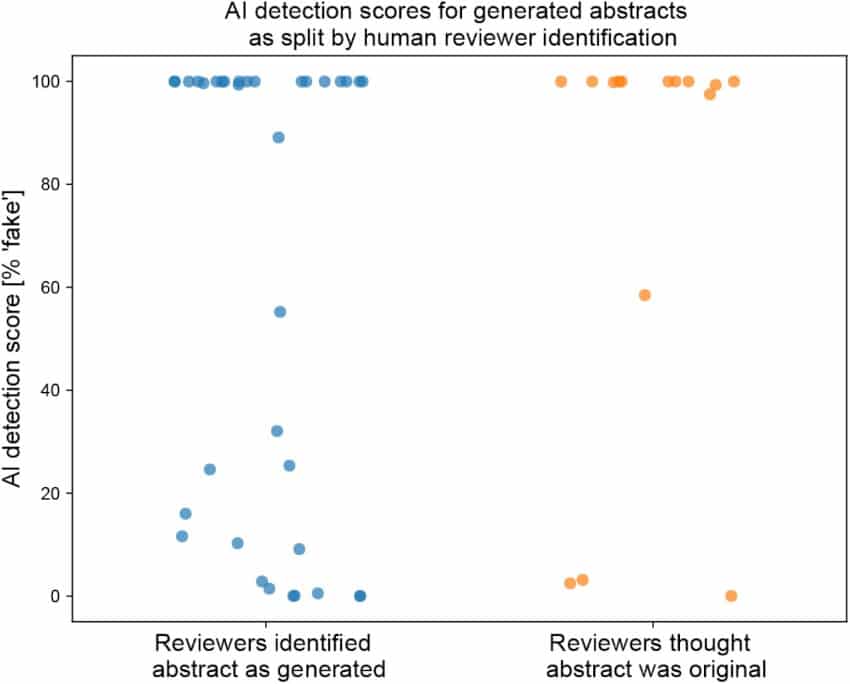

Человеческие рецензенты показали схожие результаты: они правильно определили, что 68% искусственных аннотаций были созданы ChatGPT, а 86% оригинальных статей были написаны людьми. Но это все равно означает, что 32% искусственных резюме были признаны составленными человеком, а 14% оригинальных резюме были приняты за искусственный текст... Эти рецензенты отметили, что резюме, которые они сочли искусственными, в целом были "поверхностными и расплывчатыми".

Таким образом, люди и детекторы вывода ИИ могут идентифицировать большую часть контента, генерируемого ChatGPT, но ни один из них не оказался безошибочным. Авторы исследования обеспокоены тем, что эта технология может быть использована неэтично. "Учитывая его способность генерировать сводки с достоверными цифрами, он может быть использован для полной фальсификации исследований", — отмечают они. "Это может означать, что политические решения, основанные на результатах исследования, неверны", — добавляет Сандра Вахтер. Последствия этого еще более серьезны в таких областях, как медицинские исследования, где ложная информация может угрожать безопасности людей.

Но в то же время исследователи признают, что его использование может также рассматриваться как желанная помощь, чтобы "уменьшить бремя написания и форматирования" или помочь ученым опубликоваться "на языке, который не является для них родным". Поэтому Гао и др. предлагают в таких случаях прямо указывать, что текст был написан с помощью ChatGPT, например, указывая его в качестве автора. Однако границы этичного и приемлемого использования больших лингвистических моделей для помощи в написании научных работ еще предстоит определить, заключают они.