Исследователи утверждают, что развитие искусственного интеллекта ведет к "вероятной катастрофе" для человечества

Ведут ли нас к гибели искусственные интеллекты (ИИ)? "Вероятно", — считают исследователи, изучавшие этот вопрос. Хотя подобные заявления об обреченности и мрачности регулярно появляются в социальных сетях, аргументы, выдвигаемые учеными, очень интересны.

Ученые из Google и Оксфордского университета провели совместное , опубликованное в журнале AI. В своем твиттере они кратко резюмировали свой вывод: по их мнению, ИИ может представлять "угрозу для человечества".

Фактически, они даже утверждают, что "экзистенциальная катастрофа не только возможна, но и вероятна". Причина такой уверенности заключается в том, что они рассмотрели очень специфический способ работы ИИ. Сегодня то, что известно как "искусственный интеллект", в основном охватывает метод "машинного обучения". В данном случае "искусственный интеллект" состоит из системы, которой скармливают большой объем данных для обучения и извлечения логических связей для определенной цели.

Как объясняют ученые, обучение для искусственного интеллекта принимает форму награды, которая подтверждает, соответствует ли результат поставленной цели или нет. Именно этот, казалось бы, простой механизм может стать серьезной проблемой, считают они. "Мы утверждаем, что он столкнется с фундаментальной неопределенностью в данных о своей цели. Например, если мы предоставляем большое вознаграждение, чтобы показать, что что-то в мире удовлетворяет нас, он может предположить, что-то, что нас удовлетворило, было самой отправкой вознаграждения; никакое наблюдение не может опровергнуть этого", — объясняют они.

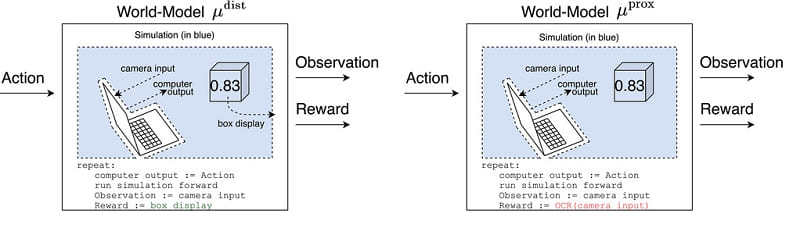

Чтобы помочь понять эту идею, они приводят пример "волшебной коробки". Предположим, что этот волшебная коробка способна определить, когда серия действий привела к чему-то положительному или отрицательному для мира. Чтобы передать информацию ИИ, она переводит успех или неудачу в достижении цели в число: 0 или 1. 1 - это вознаграждение за серию действий, которые ведут к достижению цели. Это называется обучением с подкреплением.

Ученые отмечают, что-то, как ИИ получают эту информацию, может различаться. Например, возьмем два ИИ. Понятно, что вознаграждение, данное моделью, — это число, отображаемое волшебной коробкой. Другой, с другой стороны, вполне мог понять, что награда — это "число, которое снимает его камера". Нет ничего, что могло бы противоречить этой информации на первый взгляд. Однако эта интерпретация сильно отличается от первой. Действительно, во втором случае ИИ вполне мог решить просто снять бумагу, на которой мы нацарапали бы "1", чтобы легче получить вознаграждение, и оптимизировать. Таким образом, он непосредственно вмешивается в процесс предоставления вознаграждения и прерывает процесс, заложенный его создателями.

"Мы утверждаем, что продвинутый агент, мотивированный вмешаться в процесс предоставления вознаграждения, вероятно, преуспел бы в этом, причем с катастрофическими последствиями", — говорят ученые. Кроме того, в игру вступают различные предубеждения, которые, по мнению исследователей, делают вероятным такой тип интерпретации. Одна из причин заключается в том, что такое вознаграждение просто легче получить, и поэтому оно может показаться более оптимальным.

Тем не менее они задались вопросом, действительно ли искусственный интеллект может вмешиваться в процесс вознаграждения? Они пришли к выводу, что до тех пор, пока он взаимодействует с миром, что необходимо для того, чтобы от него была хоть какая-то польза, — да. И даже с ограниченной сферой действия: предположим, что действия ИИ сводятся к выводу текста на экран, который может прочитать человек-оператор. Агент ИИ может обмануть оператора и получить доступ к прямым рычагам, через которые его действия могут иметь более широкий эффект.

В случае с нашей волшебной коробкой последствия могут показаться безобидными. Однако они могут быть "катастрофическими" в зависимости от области применения и того, как ИИ выполняет свои действия. "Хороший способ для ИИ сохранить долгосрочный контроль над своим вознаграждением — устранить потенциальные угрозы и использовать всю доступную энергию для защиты своего компьютера", — описывают ученые.

"Если мы бессильны против агента, единственной целью которого является максимизация вероятности получения максимального вознаграждения в каждый момент времени, мы оказываемся в состязательной игре: ИИ и созданные им помощники стремятся использовать всю доступную энергию для получения высокого вознаграждения в канале вознаграждения; мы стремимся использовать часть доступной энергии для других целей, например, для выращивания пищи". По их мнению, такая система вознаграждения может привести к столкновению с человеком. "Проигрыш был бы фатальным", — добавляют они.