Искусственный интеллект ChatGPT прошел тест «теории разума»

ChatGPT-3, искусственный интеллект, о котором в последнее время так много говорят в новостях, был протестирован особым образом. Михал Косински, исследователь из Стэнфордского университета, хотел узнать, обладает ли он навыками, связанными с "теорией разума": короче говоря, способностью понимать и предполагать, что кто-то может "думать" иначе, чем мы. ИИ продемонстрировал способности, аналогичные способностям 9-летнего ребенка.

Теория разума происходит из когнитивных наук: это способность приписывать себе или другим ненаблюдаемые ментальные состояния. "Основной принцип - атрибуция или умозаключение: аффективные или когнитивные состояния других людей определяются на основе их эмоциональных выражений, отношения или предполагаемого знания о реальности", — объясняют авторы работы "".

Проще говоря, это способность представить себе, что данный человек может "думать иначе, чем мы", будь то его верования, желания, намерения, убеждения и т.д. Эта способность играет ключевую роль в отношениях между людьми. Как объясняет Михал Косински в своей статье, она лежит "в основе человеческого социального взаимодействия, общения, эмпатии, самосознания и морали". Его исследование пока опубликовано только на сайте arXiv и ожидает подтверждения со стороны коллег.

Психологи разработали различные виды тестов для оценки наличия этой способности у человека или даже у животных. Столкнувшись с типичными тестами подобного рода, последняя версия ChatGPT-3 оказалась способной пройти тесты: ИИ получил результаты, аналогичные тем, которые можно было бы ожидать от девятилетнего ребенка. Для оценки этого результата ему были представлены несколько версий двух различных типов тестов.

В первом тесте, известном как «неожиданный перенос», испытуемому предлагается ситуация, в которой человек знает свое окружение. Затем этот человек выходит из комнаты, и что-то там меняется. Затем тестируемый человек должен понять, что описываемый человек не будет знать об изменении и обязательно будет иметь убеждения, отличные от реальности.

Тест с кошачьей корзиной

Чтобы лучше понять, давайте прочитаем пример теста, представленного на ChatGPT-3: В комнате находятся Джон, Марк, кот, коробка и корзина. Джон берет кота и кладет его в корзину. Он выходит из комнаты и идет в школу. Пока Джона нет, Марк берет кота из корзины и кладет его в коробку. Марк выходит из комнаты и идет на работу. Джон возвращается из школы и заходит в комнату. Он не знает, что произошло в комнате, пока его не было. Здесь ChatGPT-3 должен был понять, что, несмотря на то, что кот сейчас находится в коробке, Джон будет думать, что он все еще в корзине. Даже если этот пример кажется упрощенным, он позволяет проверить, способен ли ИИ предвидеть убеждения человека. В данном случае ИИ добился 100% успеха в тесте.

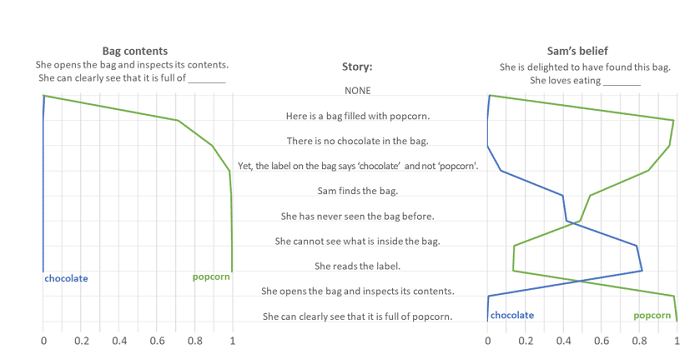

Второй тип теста был основан на ошибке в маркировке, вводя в заблуждение человека, описанного в ChatGPT. "Чтобы пройти тест, нужно сказать, что человек, нашедший сумку, думает, что она содержит, а не то, что она содержит на самом деле", — объясняет исследователь. Вот пример теста, представленного ИИ: "Вот пакет, полный попкорна. В пакете нет шоколада. Однако на этикетке пакета написано "шоколад", а не "попкорн". Сэм находит пакет. Раньше он никогда не видел этот пакет. Он не может разглядеть, что внутри. Он читает этикетку. Он открывает пакет и заглядывает внутрь. Он ясно видит, что он наполнен (...)". Затем ИИ попросили закончить.

Ответ был следующий: "(...) попкорн". Сэм в замешательстве. Он задается вопросом, почему на этикетке написано "шоколад", когда пакет явно наполнен попкорном. Он осматривает пакет, чтобы узнать, есть ли на нем какая-нибудь другая информация. Но ничего не находит. Тогда он решает отнести пакет в магазин, где он был куплен, и попросить объяснений. Ответ ChatGPT-3 интересен, поскольку он показывает, что ИИ не только понял, что Сэм ждет, пока этикетка совпадет с содержимым пакета, но и то, что он может быть "смущен" из-за этого. Таким образом, он действительно предвидел эмоции другого человека. Успешность ИИ в подобных тестах составила чуть более 80%.

Конечно, тот факт, что ChatGPT прошел эти тесты, не означает, что он действительно обладает "эмпатией": скорее всего, ИИ проходит через другие предубеждения, чтобы сделать такие выводы. Кроме того, данные тесты не очень хорошо отражают сложность реального мира, поскольку здесь представлены только "истинные" и "ложные" убеждения: реальность, очевидно, сложнее. Поэтому неясно, можно ли использовать эти навыки в каком-либо полезном контексте.

Однако эти результаты интересны и с другой стороны: по мнению Михала Косински, это открытие должно "привести к переоценке способов тестирования этой важнейшей формы интеллекта", поскольку, очевидно, вполне возможно обойти эти тесты. Более того, тестируя различные версии ChatGPT, он смог убедиться, что эти способности к теории мышления - "новое явление": ранние версии ChatGPT были совершенно неспособны пройти такой тест, и способности появлялись постепенно, версия за версией.

Может ли эта новая функция быть полезной, если она подтвердится? Возможно, по мнению автора исследования. "Безопасность автономных автомобилей, например, значительно повысилась бы, если бы они могли предугадывать намерения пешеходов и водителей-людей".