ИИ ошибается в истории: нейросети воспроизводят столетние стереотипы о неандертальцах

Исследование антропологов выявило серьезные пробелы в знаниях искусственного интеллекта о прошлом, демонстрируя, как системы ИИ могут непреднамеренно распространять устаревшие научные представления. Ученые из Университета Мэна и Чикагского университета протестировали способность популярных моделей ИИ — DALL-E 3 и GPT-3.5 — генерировать изображения и описания повседневной жизни неандертальцев, основанные на актуальных научных данных. Результаты, опубликованные в журнале Advances in Archaeological Practice, показали, что почти половина сгенерированных текстовых ответов содержала устаревшую информацию, а изображения часто воспроизводили стереотипы столетней давности.

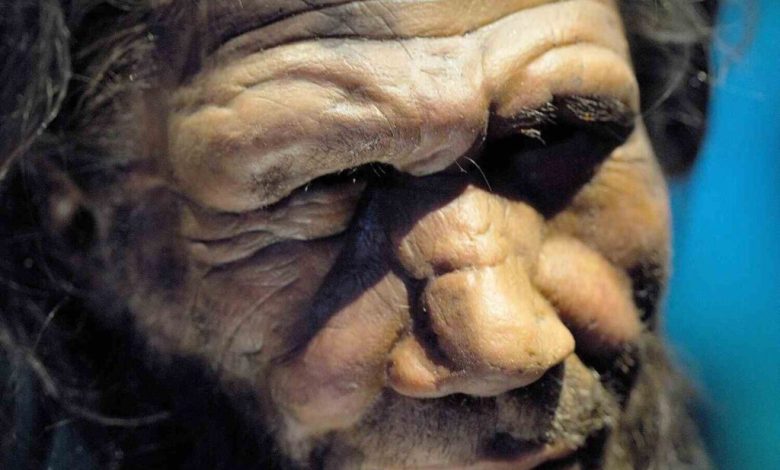

Исследователи дали моделям четыре различных запроса, часть из которых напрямую требовала научной точности в описании деятельности, контекста, одежды и орудий труда неандертальцев. Каждый запрос повторялся сто раз для статистической значимости. Анализ ответов выявил значительное расхождение с современными археологическими и антропологическими знаниями. Сгенерированные изображения часто изображали неандертальцев согласно научным представлениям XIX и начала XX века: с чрезмерно примитивными, обезьяноподобными чертами лица, обильной волосатостью и сутулой осанкой. Кроме того, в сценах практически отсутствовали женщины и дети, что не отражает сложности и разнообразия неандертальских сообществ, известных сегодня. В некоторых описаниях и на изображениях фигурировали предметы, такие как плетеные корзины, соломенные крыши, металлические и стеклянные объекты, что является явным анахронизмом для той эпохи.

Как пояснил ведущий автор , доцент антропологии Мэтью Маньяни, точность ответов ИИ напрямую зависела от их способности получить доступ к актуальным и надежным источникам информации. Проследив источники данных для моделей, ученые обнаружили, что GPT-3.5 в значительной степени опирался на исследования 1960-х годов, а DALL-E 3 — на данные конца 1980-х — начала 1990-х годов. Это объясняет, почему выводы ИИ не соответствуют современным научным парадигмам.

Эксперименты были проведены в 2023 году, и авторы надеются, что текущие и будущие версии чат-ботов, с учетом быстрого развития отрасли и пересмотра подходов к авторским правам, будут лучше интегрировать новейшие научные данные. Соавтор работы, специалист по вычислительной антропологии Джон Клинданиэл, подчеркнул, что одним из ключевых путей повышения точности ИИ является обеспечение его доступа к современным антропологическим данным и научным публикациям.

Исследование служит тревожным сигналом о потенциальных рисках, связанных с растущим использованием генеративного ИИ в образовании и науке. Легкость создания правдоподобного, но научно неточного контента может привести к закреплению устаревших стереотипов и распространению дезинформации о прошлом, что в долгосрочной перспективе способно повлиять на общественное понимание истории и подорвать доверие к десятилетиям научных исследований. По словам Маньяни, данная работа также предлагает методику, которая позволит другим ученым систематически оценивать разрыв между актуальными исследованиями и контентом, создаваемым искусственным интеллектом.