Австралийские ученые разработали защиту от неавторизованного обучения ИИ

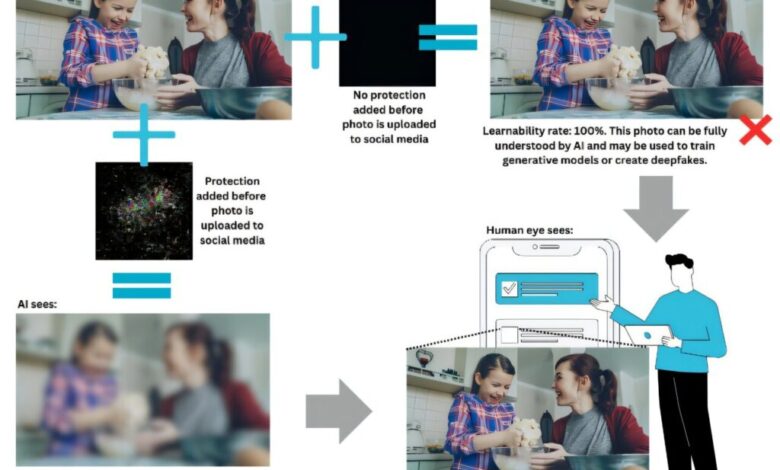

Исследователи из Австралии создали новый метод, который предотвращает использование онлайн-контента для обучения искусственного интеллекта без разрешения. Технология незаметно изменяет данные, делая их нечитаемыми для алгоритмов ИИ, но сохраняя исходный вид для человеческого глаза. Пока метод применяется только к визуальному контенту, но в будущем его планируют адаптировать для текстов, аудио и видео.

Проблема неконтролируемого обучения ИИ на основе публичных данных уже несколько лет вызывает беспокойство как у обычных пользователей, так и у создателей контента. Люди опасаются, что их личные фото и публикации могут быть использованы без их ведома, а художники и авторы протестуют против включения их работ в обучающие наборы ИИ. Это привело к многочисленным судебным искам и петициям против компаний, разрабатывающих ИИ.

Например, в марте этого года возник скандал вокруг функции ChatGPT «Ghibli Effect», которая генерировала изображения в стиле японской анимационной студии Ghibli. Хотя авторские права не защищают стиль как таковой, ситуация вызвала споры о границе между вдохновением и плагиатом. В апреле OpenAI ограничил некоторые запросы, связанные с Ghibli, сославшись на внутренние правила.

Существующие методы защиты, такие как файлы robots.txt, не всегда эффективны, и около 25% сайтов уже вводят ограничения на сбор данных ИИ. Однако текущие технологии не гарантируют полной безопасности, поскольку алгоритмы могут обходить некоторые виды защиты.

Новый , разработанный учеными из Commonwealth Scientific and Industrial Research Organisation (CSIRO), а также специалистами Cyber Security Cooperative Research Center (CSCRC) и Университета Чикаго, обеспечивает математически подтвержденную защиту. В отличие от предыдущих решений, он устанавливает четкий предел того, что ИИ может извлечь из защищенного контента, даже при попытках обхода.

«Современные методы защиты основаны на предположениях о поведении ИИ, но наша технология дает гарантированный результат», — пояснил Деруи Ван, ведущий автор исследования.

Технология может помочь художникам защитить свои работы от несанкционированного использования, а пользователям соцсетей — снизить риск создания deepfake-контента. Например, она позволяет автоматически накладывать защитный слой на фото перед загрузкой или маскировать чувствительные спутниковые снимки.

Пока метод тестировался только в лабораторных условиях, и для подтверждения его эффективности требуются дополнительные испытания. Исходный код доступен на GitHub для академического использования, а разработчики ищут партнеров в сферах кибербезопасности, этики ИИ и обороны.